Nvidia presenta NVLink Fusion para integrar CPUs y ASICs en centros de datos de inteligencia artificial

Nvidia impulsa la innovación en inteligencia artificial con NVLink Fusion, facilitando la integración de diferentes procesadores en centros de datos.

Nvidia ha anunciado una serie de innovaciones y productos para consolidar su liderazgo en el desarrollo de inteligencia artificial y computación avanzada. Entre las novedades destaca el programa NVLink Fusion, una plataforma que permitirá a clientes y socios utilizar procesadores de terceros, tanto CPUs como ASICs, junto con las GPUs de Nvidia y su tecnología NVLink. Hasta ahora, NVLink era exclusivo para chips fabricados por Nvidia; con esta iniciativa, la compañía busca facilitar infraestructuras de IA semipersonalizadas que integren diferentes componentes, ampliando su alcance en los centros de datos.

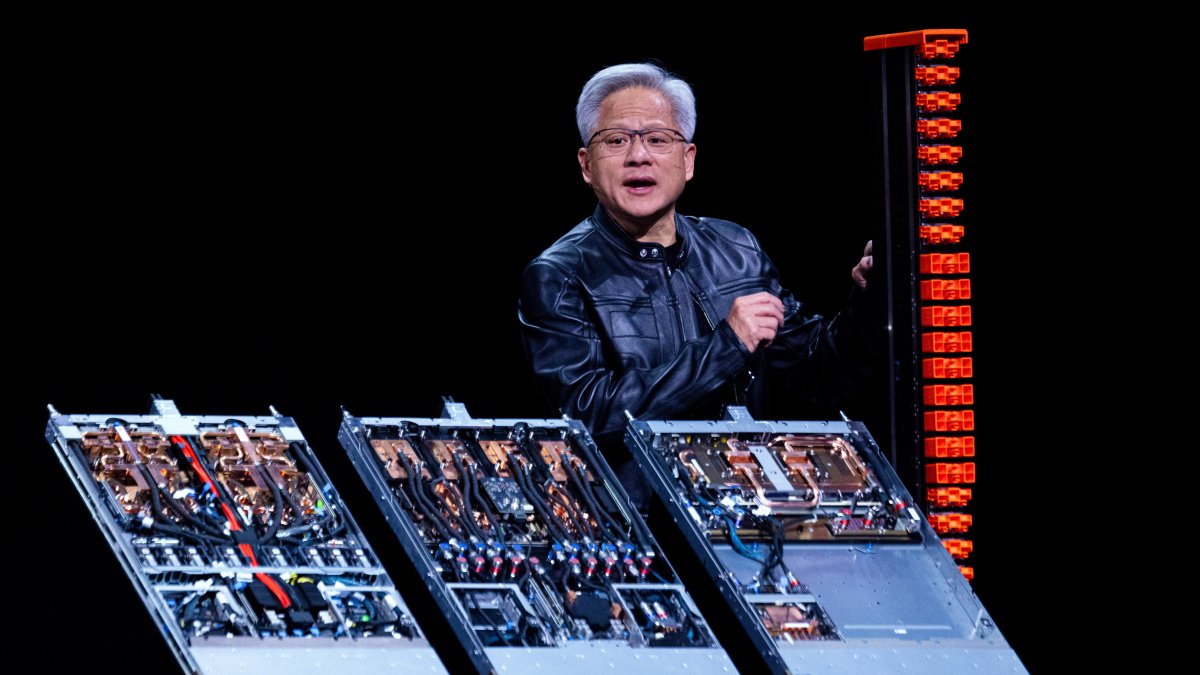

Jensen Huang, CEO de Nvidia, explicó durante la conferencia Computex 2025 en Taiwán que NVLink Fusion posibilita combinar procesadores Nvidia con CPUs de compañías como MediaTek, Marvell, Alchip, Astera Labs, Synopsys y Cadence, además de permitir que socios como Fujitsu y Qualcomm conecten sus propios CPUs con las GPUs de Nvidia en centros de datos de IA. Esta estrategia busca captar mayor cuota en centros de datos basados en ASICs, un segmento en el que Nvidia ha visto tradicionalmente a sus competidores como Google, Microsoft y Amazon desarrollando sus propios procesadores para procesos específicos.

Expertos como Ray Wang consideran que NVLink Fusion posiciona a Nvidia como el elemento central en las futuras fábricas de IA, incluso en sistemas que no están compuestos enteramente por chips Nvidia. La iniciativa abre oportunidades para colaborar con diseñadores de CPUs y ASICs, fortaleciendo su presencia en el mercado. Sin embargo, algunos analistas advierten que esta flexibilidad puede reducir la demanda de CPUs Nvidia, permitiendo a los clientes optar por componentes de otros fabricantes.

En línea con estas innovaciones, Nvidia también presentó su próxima generación de sistemas Grace Blackwell, el modelo GB300, que se lanzará en el tercer trimestre del año y ofrecerá un rendimiento superior para cargas de trabajo de IA. Además, anunció la plataforma DGX Cloud Lepton, un sistema en la nube que conectará a desarrolladores con miles de GPUs distribuidas globalmente a través de diferentes proveedores de servicios en la nube, facilitando el acceso a recursos de alta capacidad y seguridad en el procesamiento de IA.

Por otra parte, Huang comentó que Nvidia planea abrir una oficina en Taiwán y contribuir a la construcción de un superordenador de inteligencia artificial en colaboración con Foxconn, la mayor fabricante de componentes electrónicos del mundo. Este proyecto apunta a fortalecer la infraestructura de IA en la región, apoyando a empresas como TSMC y fomentando la innovación en robótica y tecnología avanzada.