Nvidia lanza el acelerador Rubin CPX en 2026 para mejorar el rendimiento en modelos de inteligencia artificial complejos

Nvidia presenta Rubin CPX, un acelerador de última generación que revolucionará el procesamiento de modelos de inteligencia artificial avanzados.

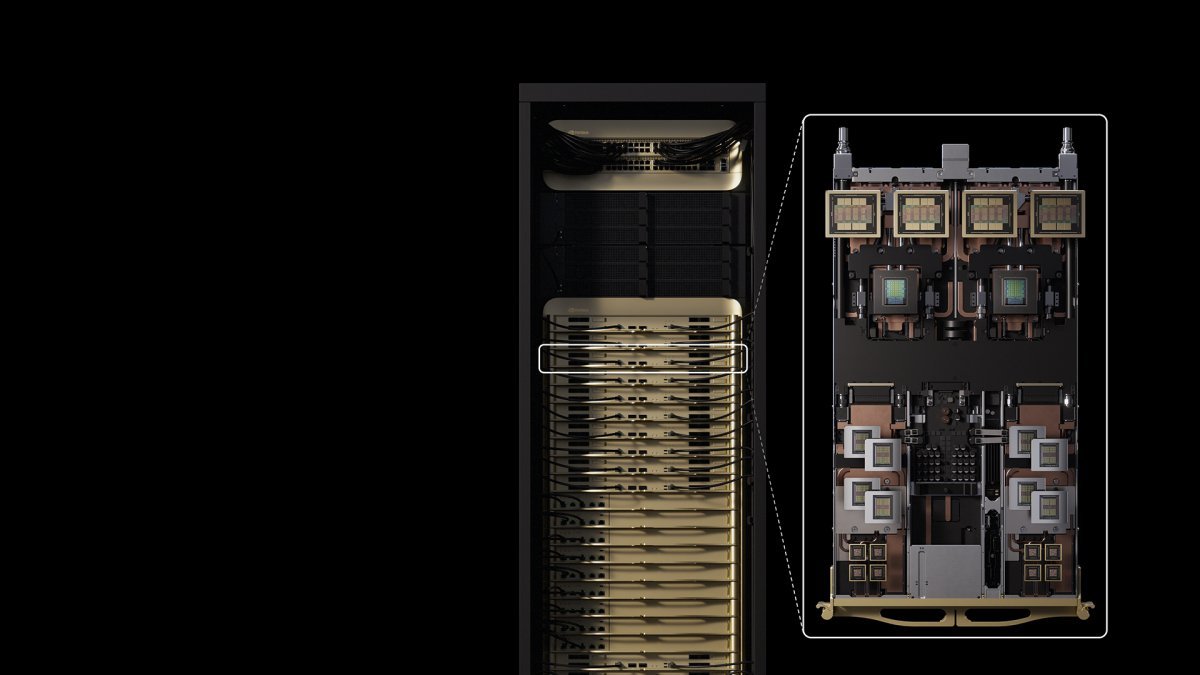

Nvidia lanzará a finales de 2026 el Rubin CPX, un acelerador especializado en potenciar aplicaciones de inteligencia artificial con altas demandas de contexto. Este nuevo chip forma parte de la generación Vera-Rubin, destinada a centros de datos de alta eficiencia, y ya ha completado su proceso de diseño y pruebas iniciales, estando preparado para integrarse en racks o como unidad adicional en sistemas existentes.

El Rubin CPX está diseñado para abordar los cuellos de botella en el procesamiento de modelos de IA que utilizan la técnica Mixture-of-Experts (MoE). Este método combina múltiples redes neuronales especializadas para atender distintas partes de una consulta, optimizando recursos y reduciendo los requisitos de memoria y cálculo en cada experto individual. Sin embargo, la coordinación entre estos expertos, especialmente en tareas complejas como el razonamiento, incrementa la complejidad y la demanda de comunicación interna entre componentes.

Una de las innovaciones clave del nuevo acelerador es la técnica de servicio desagregado, que separa las fases de gestión del contexto y preprocesamiento en distintos aceleradores. Este enfoque ha demostrado mejorar el rendimiento entre un 40% y un 45%, optimizando significativamente la eficiencia en el procesamiento de grandes cantidades de datos y tokens. Como se ha visto en sistemas actuales, como las configuraciones Blackwell de Nvidia, esta optimización permite distribuir y acelerar específicamente la generación de contenido y la gestión del contexto, maximizando los recursos del hardware.

Además, Nvidia ha aprovechado las propiedades de los modelos de lenguaje mediante la reducción de la precisión en el cálculo, utilizando su formato NVFP4 de 4 bits con exponente compartido, que resulta suficiente para mantener la precisión necesaria en las inferencias de aprendizaje automático y análisis de datos complejos. Gracias a esta tecnología, los sistemas basados en la arquitectura Blackwell Ultra ya alcanzan un rendimiento de hasta 10,7 billones de operaciones por segundo en este formato, permitiendo escalar hasta 8 exa-flops en configuraciones de racks Rubin CPX, con una memoria GDDR7 de 128 Gbyte.

Se espera que Rubin CPX supere en capacidad el rendimiento actual de los sistemas GB300, que alcanzan 1,1 exa-flops, y del futuro NVL144, que llega a 3,6 exa-flops. Con ello, Nvidia apunta a triplicar el throughput en comparación con los equipos actuales, estableciendo nuevos estándares en el procesamiento intensivo de modelos de IA que requieren manejar volúmenes de tokens cada vez mayores y respuestas más complejas, como programación, generación de vídeos artificiales o análisis avanzado de datos en tiempo real.