Tensión entre Nvidia y OpenAI por acuerdos no vinculantes y diversificación de hardware

Nvidia y OpenAI enfrentan tensiones debido a acuerdos no vinculantes y la búsqueda de diversificación en suministro de hardware.

La relación entre Nvidia y OpenAI atraviesa un momento de tensión, a pesar de que ambos socios hayan expresado públicamente su aprecio por la colaboración. Recientemente, el CEO de OpenAI, Sam Altman, publicó en X una declaración en la que manifestó su satisfacción por trabajar con Nvidia, calificando sus chips de inteligencia artificial como los mejores del mercado y expresando su deseo de mantener una relación prolongada. Sin embargo, existen indicios de problemas internos que complican esta relación.

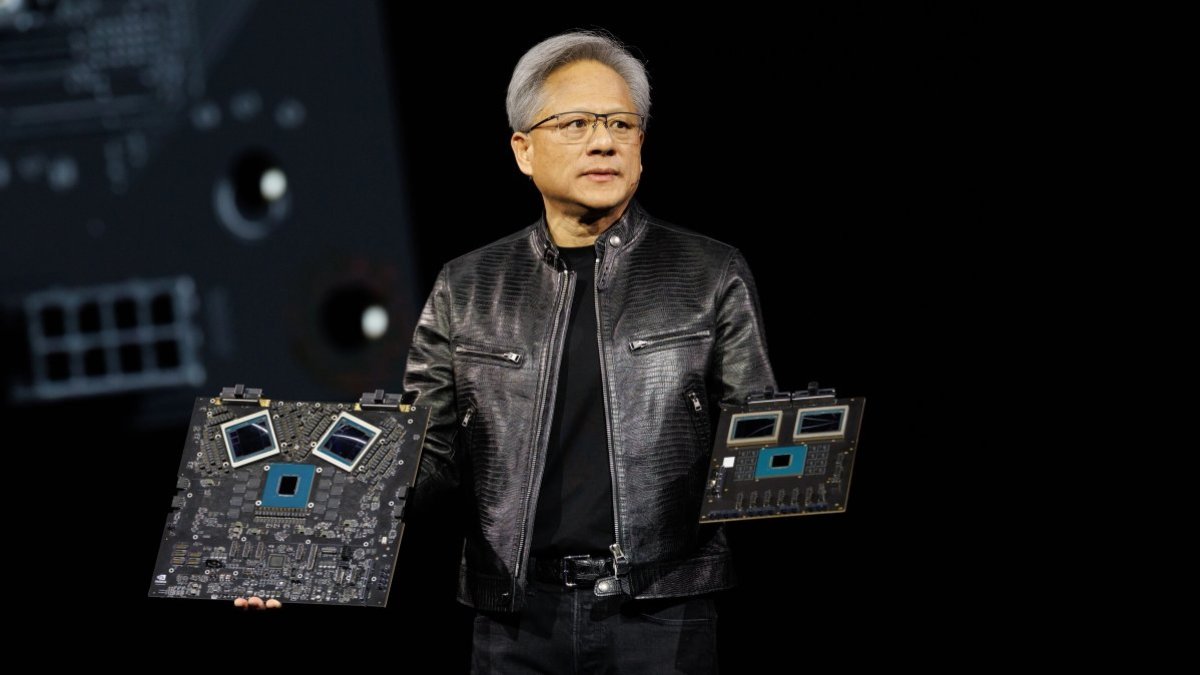

Uno de los aspectos que ha generado dudas es un acuerdo de 100.000 millones de dólares firmado en septiembre de 2025, que aún no se ha materializado. Nvidia ha declarado que dicho acuerdo no es vinculante y que su CEO, Jensen Huang, considera que el pacto no tiene obligatoriedad. Además, Huang expresó su interés en invertir en OpenAI, pero solo en la escala que considere adecuada, negándose a comprometerse con cifras tan elevadas.

Por otro lado, OpenAI ha mostrado insatisfacción con los aceleradores de inferencia de Nvidia, buscando alternativas más integradas en cuanto a memoria. La empresa pretende reducir la latencia mediante tecnologías que incorporen mayor cantidad de memoria SRAM directamente en los chips, en lugar de depender de memoria externa como GDDR7 o HBM. En respuesta, ha comenzado a diversificar su suministro de hardware, firmando acuerdos con otras compañías como AMD, Cerebras y está en negociaciones con Groq.

Con estos acuerdos, OpenAI busca reducir su dependencia de Nvidia. La empresa ha concretado un contrato con AMD para adquirir aceleradores con mayor capacidad de caché, comenzando en 2025 con la serie Instinct MI400, que incorpora memorias más grandes que las de Nvidia. En enero de 2026, firmó una asociación con Cerebras para adquirir sus chips de escala de oblea (WSE), que cuentan con hasta 44 Gbytes de SRAM y una capacidad total de 750 megavatios hasta 2028. Además, negocia con Groq para obtener aceleradores especializados en inferencia, aunque Nvidia ya ha licenciado parte de esta tecnología y ha incorporado al equipo de diseño.

Se proyecta que en el futuro los aceleradores con menor latencia representen aproximadamente un 10% del total del hardware de inferencia de OpenAI, dirigido principalmente a clientes que requieran respuestas rápidas. El hardware de Nvidia probablemente seguirá dominando la infraestructura del gigante de la inteligencia artificial.

Todo este contexto ha afectado también la cotización de Nvidia en bolsa, que ha recortado valor en comparación con otras compañías del sector, reflejando las complicaciones internas y la pérdida de confianza en una pronta renovación de la colaboración con OpenAI.